Un modello controllo dei fatti ti aiuta a verificare in modo semplice la qualità e l’affidabilità delle risposte generate da un’intelligenza artificiale. Integrare una Fact Check List Pattern migliora la coerenza, la precisione e l’utilità dell’output.

Molti utenti si fidano ciecamente dell’AI. Ma anche un buon modello linguistico può produrre errori o affermazioni prive di fonti (allucinazioni dell’intelligenza artificiale generativa). Ecco perché serve una struttura: uno schema oggettivo che guida l’utente nel valutare, correggere o rigenerare una risposta.

Questo articolo ti mostra passo dopo passo come costruire e applicare un modello di controllo dei fatti efficace, con esempi pratici e tecniche collaudate, anche se non hai conoscenze tecniche.

Su Alunia, aiutiamo aziende, agenzie e professionisti a usare l’AI in modo strategico: chatbot intelligenti, automazione, creazione contenuti e formazione personalizzata. Il nostro approccio punta su prompt avanzati e strutturati per risultati affidabili.

Nel resto dell’articolo vedrai:

- Quando usare un Fact Check Pattern

- Quali elementi includere

- Come adattarlo a contesti aziendali

Cos’è un Modello Controllo dei Fatti e Perché È Utile

Il modello controllo dei fatti è uno schema di verifica pensato per valutare la qualità e la coerenza di un output generato da un’intelligenza artificiale. Non si tratta solo di correggere errori evidenti, ma di strutturare un controllo semantico su più livelli: logica, accuratezza, rilevanza e contesto.

Questa checklist ha lo scopo di ridurre i bias impliciti, identificare affermazioni non supportate da dati e migliorare l’aderenza al prompt originale. È una tecnica particolarmente utile per chi utilizza l’AI in ambiti dove l’accuratezza è prioritaria: formazione, comunicazione, contenuti informativi, customer service e documentazione tecnica.

Adottare un modello di controllo aiuta anche a sviluppare un approccio più consapevole nell’uso dei tool generativi, spingendo l’utente a domandarsi “Questa risposta ha senso?”, “Le fonti sono implicite ma affidabili?”, “Rispecchia davvero l’intento iniziale?”

Tra i vantaggi principali:

- Evita risposte ambigue o facilmente fraintendibili

- Rafforza il contesto dell’output e la sua coerenza con la domanda

- Favorisce un uso critico dell’AI, non passivo

- Funziona anche per prompt articolati e multi-step

Per ottenere risposte AI coerenti e rilevanti, è utile combinare questo schema con tecniche come il Prompt Contesto Esteso, che migliora la qualità a monte.

Strumenti come il modello proposto dalla Harvard Library tra le risorse per il fact-checking forniscono criteri consolidati per valutare l’affidabilità dei contenuti, e rappresentano una base solida anche per i controlli nell’ambito AI.

Come Funziona il Fact Check List Pattern

Il Fact Check List Pattern è una struttura di verifica oggettiva, basata su una serie di domande chiave che permettono di analizzare la qualità delle risposte fornite dall’intelligenza artificiale. Il modello segue quattro assi principali: logica, pertinenza, affidabilità delle fonti e aggiornamento del contenuto.

L’obiettivo non è solo quello di identificare errori evidenti, ma di garantire che l’output sia conforme all’intento iniziale del prompt, semanticamente corretto e contestualizzato. È una tecnica applicabile a ogni settore, dalla creazione di contenuti alla documentazione tecnica, dalla formazione alla comunicazione automatizzata.

L’efficacia del pattern aumenta se l’AI è configurata correttamente con un system prompt ben definito, così da orientare le risposte verso coerenza, chiarezza e finalità specifiche. Puoi approfondire come farlo nella guida su come configurare ChatGPT per risposte efficaci.

Le 6 domande base del pattern

Un modello di controllo efficace si basa su sei domande fondamentali. Ogni output dovrebbe passare questo filtro prima di essere considerato utilizzabile:

- È logicamente coerente?

L’output segue un filo logico o contiene contraddizioni? - Risponde davvero alla domanda iniziale?

Verifica se l’AI ha capito e centrato l’intento. - Usa fonti attendibili o verosimili?

Anche senza link, valuta la plausibilità delle affermazioni. - Presenta dati o solo opinioni?

Un contenuto utile dovrebbe contenere fatti verificabili. - È aggiornata rispetto al contesto?

L’output riflette uno scenario attuale o informazioni obsolete? - Può essere fraintesa?

Il linguaggio è chiaro, o lascia spazio a interpretazioni errate?

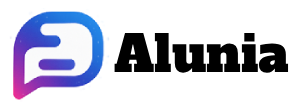

Tipi di errori AI comuni

Per applicare il modello in modo consapevole, è utile conoscere le tipologie di errore più frequenti:

- Confusione tra entità simili: esempio classico è l’inversione tra “ONU” e “UNESCO”

- Datazioni errate: eventi spostati di anni o contesti temporali non coerenti

- Invenzione di fonti: l’AI può citare fonti che non esistono o non supportano davvero l’affermazione

- Salti logici: conclusioni tratte senza giustificazione o connessioni forzate

Queste situazioni mostrano quanto sia importante integrare controlli oggettivi anche su risposte apparentemente corrette.

Come Costruire un Tuo Modello Controllo dei Fatti

Creare un modello controllo dei fatti personalizzato ti permette di adattare il processo di verifica ai tuoi obiettivi specifici, sia che tu stia lavorando su articoli divulgativi, materiali formativi, documentazione tecnica o contenuti per chatbot aziendali.

La costruzione di questo modello parte da una griglia essenziale di elementi da controllare, ciascuno associato a una domanda guida e a un’azione correttiva concreta. Questo approccio rende il controllo replicabile, oggettivo e facile da integrare nel tuo flusso di lavoro, anche quando il contenuto è generato automaticamente.

L’efficacia aumenta se il prompt iniziale è già strutturato correttamente. Tecniche come il Prompt Recipe Pattern, il modello di prompt strutturato offrono un’ottima base per ottenere risposte più vicine allo scopo, riducendo la necessità di correzioni successive.

Struttura consigliata del tuo Fact Check Pattern

| Elemento da valutare | Domanda da porsi | Azione suggerita |

|---|---|---|

| Coerenza logica | Il testo ha senso? | Riformula la parte ambigua |

| Completezza | Manca qualcosa di importante? | Aggiungi un prompt chiarificatore |

| Aderenza alla domanda | Risponde davvero alla query iniziale? | Rigenera con prompt più specifico |

| Uso di fonti (esplicite/implicite) | Sono presenti riferimenti affidabili? | Inserisci riferimenti più chiari |

| Stile e tono | È adatto al pubblico destinatario? | Modifica il tono nel prompt |

Questo schema può essere stampato o integrato in strumenti di lavoro collaborativi, come Notion o Google Docs, per essere usato in tempo reale durante l’analisi delle risposte AI.

Quando Usare il Modello Controllo dei Fatti

Il Fact Check List Pattern non deve essere applicato a ogni risposta generata dall’AI, ma è altamente consigliato in contesti dove accuratezza, coerenza e affidabilità sono elementi critici. In questi casi, un controllo post-output diventa uno strumento essenziale per garantire qualità e ridurre errori, soprattutto in ambienti dove il contenuto viene pubblicato, automatizzato o utilizzato per decisioni operative.

3 contesti ideali

1. Creazione contenuti informativi

Quando si scrivono articoli di blog, white paper o guide operative, la verifica delle affermazioni è cruciale. Il modello aiuta a evitare superficialità, omissioni e affermazioni infondate, migliorando l’affidabilità del contenuto e la fiducia degli utenti.

2. Formazione e learning

Nel contesto educativo, le risposte AI devono essere logicamente corrette e didatticamente utili. Il controllo serve per correggere errori e rinforzare l’apprendimento. Un buon esempio di applicazione interattiva è il Prompt Game Play Pattern, dove il fact-checking contribuisce alla verifica immediata delle risposte.

3. Automazione con chatbot AI

Quando un chatbot AI risponde in modo automatico, è essenziale verificare le risposte prima della messa in produzione. Il Fact Check Pattern consente di validare i messaggi generati, soprattutto quelli su argomenti sensibili o regolamentati, riducendo i rischi operativi.

Esempi pratici di applicazione:

- Generazione di articoli SEO con dati o riferimenti

- Customer care automatizzato con risposte tecniche

- Email generative personalizzate per campagne di marketing

L’efficacia del controllo aumenta se combinata con modelli di ragionamento multi-step, come nei prompt a catena per ottenere risposte logiche, che aiutano l’AI a costruire risposte coerenti già in fase di generazione.

Come Migliorare il Tuo Prompt per Ottenere Risposte più Controllabili

Corso Gratuito Prompt Engineering

Ottieni gratuitamente il nostro corso introduttivo su Prompt Engineering. Unisciti a centinaia di lettori e impara subito a creare prompt efficaci con l’Intelligenza Artificiale. Inserisci il tuo indirizzo email qui sotto per ricevere il PDF direttamente nella tua casella di posta.

Il livello di controllo che puoi esercitare su una risposta AI dipende in gran parte da come scrivi il prompt iniziale. Se il prompt è generico o ambiguo, l’output sarà approssimativo o incompleto. Al contrario, un prompt ben strutturato, con parametri chiari e aspettative definite, riduce drasticamente la necessità di interventi correttivi.

Per aumentare la precisione, è utile variare il modello di costruzione del prompt in base all’obiettivo comunicativo. Tecniche come il Prompt Alternative Approaches Pattern aiutano a generare alternative strategiche, stimolando l’AI a produrre soluzioni più aderenti al contesto desiderato.

Usa i Few-shot Examples

Uno dei metodi più efficaci per rendere le risposte AI più controllabili fin dalla generazione è l’uso di esempi all’interno del prompt, noti come few-shot examples. In pratica, si mostra all’AI il tipo di output desiderato fornendo da uno a tre esempi concreti.

Questa tecnica consente di:

- Mostrare chiaramente cosa intendi, evitando interpretazioni errate

- Eliminare ambiguità, guidando lo stile, la forma e il contenuto della risposta

- Ridurre il bisogno di fact-check post-output, perché l’AI segue un modello esplicito

I prompt con esempi per risultati efficaci sono particolarmente utili nei contesti dove la precisione è fondamentale, come nella scrittura tecnica, nella generazione di codice, o nella comunicazione regolamentata. Scopri come strutturarli nella guida su prompt con esempi per risultati efficaci.

Conclusione

Il modello controllo dei fatti è molto più di una semplice lista di controllo: è un filtro critico che trasforma un output AI qualunque in un contenuto utile, affidabile e pronto per essere usato in contesti professionali, didattici o creativi.

Quando usi l’intelligenza artificiale senza validarne le risposte, rischi di diffondere errori, distorsioni o messaggi fuorvianti. Con un Fact Check List Pattern ben strutturato, invece, assumi il controllo del processo.

Cosa porti a casa da questo articolo

- Applica domande guida al tuo output: logica, fonti, coerenza, tono.

- Adatta la checklist al tuo ambito (marketing, didattica, editoria, ecc.).

- Migliora i prompt iniziali per generare risposte più solide.

- Valuta sempre l’output come faresti con un contenuto umano.

🔗 Approfondimento utile:

Per usare davvero l’AI in modo professionale, scopri la nostra 👉 consulenza in intelligenza artificiale

Progetti su misura, senza tecnicismi inutili.

🔗 Fonte esterna consigliata:

Leggi anche i principi UE per la verifica dell’informazione digitale: un riferimento utile per chi crea o valida contenuti con strumenti AI.

Controllare non è sfiducia: è responsabilità.

In un’epoca in cui l’AI genera contenuti in pochi secondi, il vero valore appartiene a chi sa valutarli con metodo, rigore e spirito critico. Non fidarti della forma: validane la sostanza.